En un contexto donde se debate sobre una posible burbuja de la inteligencia artificial (IA), con temores de sobreinversión y un posible estallido, empresas como Google y OpenAI enfrentan un desafío: construir infraestructura a un ritmo que apenas logra satisfacer sus necesidades en este campo.

Durante una reunión interna a principios de este mes, Amin Vahdat, responsable de la infraestructura de IA de Google, comunicó a los empleados que la compañía debe duplicar su capacidad de servicio cada seis meses para cumplir con la creciente demanda de servicios de inteligencia artificial, según informó CNBC. Estos comentarios ofrecen una visión poco común de la información que los ejecutivos de Google comparten internamente. Vahdat, vicepresidente de Google Cloud, presentó diapositivas que ilustraban la necesidad de la empresa de escalar “las próximas 1000x en 4-5 años”.

Si bien un aumento de mil veces en la capacidad de cómputo ya suena ambicioso, Vahdat señaló algunas limitaciones clave: Google necesita poder ofrecer este aumento en capacidad, cómputo y redes de almacenamiento “esencialmente por el mismo costo e, idealmente, con el mismo consumo de energía”, explicó a los empleados durante la reunión. “No será fácil, pero a través de la colaboración y el diseño conjunto, lo lograremos”.

No está claro en qué medida esta “demanda” mencionada por Google representa el interés orgánico de los usuarios en las capacidades de IA, o la integración de funciones de IA en servicios existentes como Search, Gmail y Workspace. Pero, independientemente de si los usuarios utilizan las funciones voluntariamente o no, Google no es la única empresa tecnológica que lucha por mantenerse al día con una base de clientes en crecimiento que utiliza servicios de IA.

Las principales empresas tecnológicas están inmersas en una carrera por construir centros de datos. OpenAI, competidor de Google, está planeando construir seis centros de datos masivos en los Estados Unidos a través de su proyecto de asociación Stargate con SoftBank y Oracle, comprometiendo más de $400 mil millones en los próximos tres años para alcanzar casi 7 gigavatios de capacidad. La compañía enfrenta limitaciones similares para atender a sus 800 millones de usuarios semanales de ChatGPT, con suscriptores de pago que regularmente alcanzan los límites de uso para funciones como la síntesis de video y los modelos de razonamiento simulado.

“La competencia en infraestructura de IA es la parte más crítica y también la más costosa de la carrera de la IA”, dijo Vahdat en la reunión, según la visualización de la presentación por parte de CNBC. El ejecutivo de infraestructura explicó que el desafío de Google va más allá de simplemente gastar más que sus competidores. “Vamos a gastar mucho”, dijo, pero señaló que el objetivo real es construir una infraestructura que sea “más confiable, más eficiente y más escalable que lo que está disponible en cualquier otro lugar”.

El desafío de la escalabilidad de mil veces

Un cuello de botella importante para satisfacer la demanda de IA ha sido la falta de capacidad de Nvidia para producir suficientes GPU que aceleren los cálculos de IA. Hace apenas unos días, durante un informe trimestral de ganancias, Nvidia dijo que sus chips de IA están “agotados” mientras corre para satisfacer la demanda que hizo crecer los ingresos de su centro de datos en $10 mil millones en un solo trimestre.

La falta de chips y otras limitaciones de infraestructura afectan la capacidad de Google para implementar nuevas funciones de IA. Durante la reunión general del 6 de noviembre, el CEO de Google, Sundar Pichai, citó el ejemplo de Veo, la herramienta de generación de video de Google que recibió una actualización el mes pasado. “Cuando se lanzó Veo, qué emocionante fue”, dijo Pichai. “Si pudiéramos haberlo dado a más personas en la aplicación Gemini, creo que habríamos conseguido más usuarios, pero simplemente no pudimos porque estamos en una restricción de cómputo”.

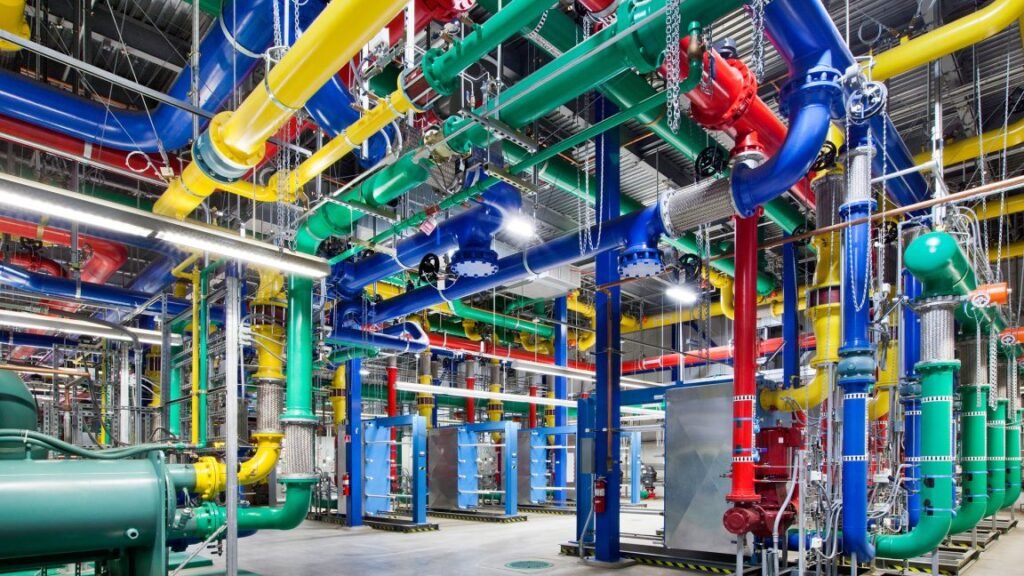

En la misma reunión, la presentación de Vahdat describió cómo Google planea alcanzar sus objetivos de escalamiento masivo sin simplemente arrojar dinero al problema. La compañía planea confiar en tres estrategias principales: construir infraestructura física, desarrollar modelos de IA más eficientes y diseñar chips de silicio personalizados.

El uso de sus propios chips significa que Google no necesita depender completamente del hardware de Nvidia para construir sus capacidades de IA. A principios de este mes, por ejemplo, Google anunció la disponibilidad general de su Unidad de Procesamiento Tensor (TPU) de séptima generación llamada Ironwood. Google afirma que es “casi 30 veces más eficiente energéticamente” que su primera Cloud TPU de 2018.

Dado el reconocimiento generalizado de una posible burbuja de la industria de la IA, incluidos los extensos comentarios de Pichai en una entrevista reciente con la BBC, los planes agresivos para la expansión del centro de datos de IA reflejan el cálculo de Google de que el riesgo de subinversión excede el riesgo de sobrecapacidad. Pero es una apuesta que podría resultar costosa si la demanda no continúa aumentando como se esperaba.

En la reunión general, Pichai dijo a los empleados que 2026 será “intenso”, citando tanto la competencia de la IA como la presión para satisfacer la demanda de la nube y el cómputo. Pichai abordó directamente las preocupaciones de los empleados sobre una posible burbuja de IA, reconociendo que el tema ha estado “definitivamente en el zeitgeist”.

Fuente original: ver aquí