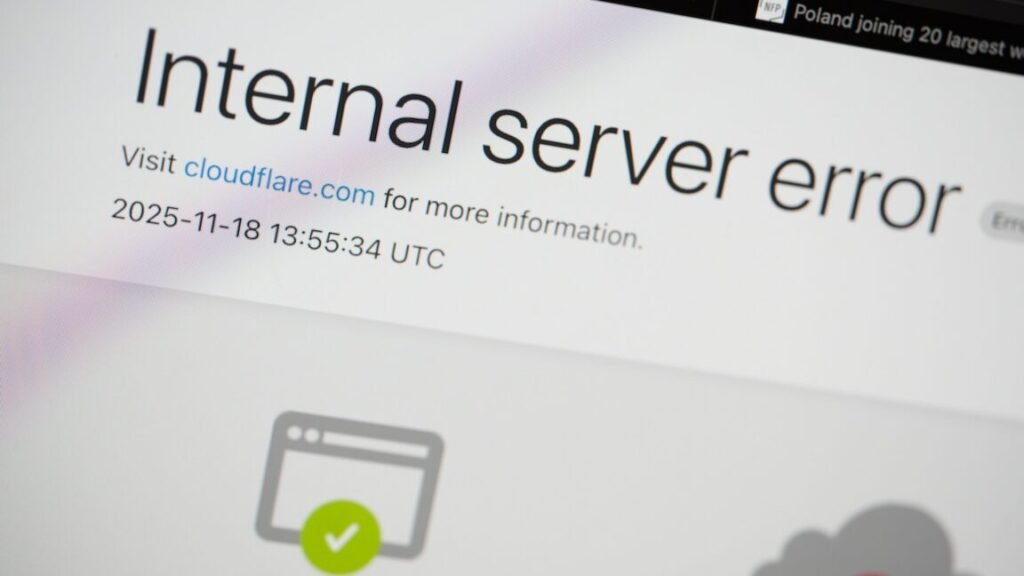

Una interrupción en Cloudflare afectó a numerosos sitios web y servicios en línea. Inicialmente, la compañía sospechó de un ataque DDoS (denegación de servicio distribuido) de “hiperescala”.

Matthew Prince, cofundador y CEO de Cloudflare, expresó su preocupación en un chat interno sobre la posibilidad de un ataque de la botnet Aisuru. Sin embargo, tras una investigación más profunda, el personal de Cloudflare determinó que el problema tenía una causa interna: un archivo importante había duplicado su tamaño de forma inesperada y se había propagado por toda la red.

Este incidente afectó al software encargado de leer el archivo para mantener el sistema de gestión de bots de Cloudflare, que utiliza un modelo de aprendizaje automático para proteger contra amenazas de seguridad. Los servicios principales de CDN (red de entrega de contenido), los servicios de seguridad y otros servicios de Cloudflare se vieron comprometidos.

En un análisis posterior a la interrupción, Prince declaró que, tras sospechar inicialmente de un ataque DDoS de hiperescala, identificaron correctamente la causa principal y pudieron detener la propagación del archivo de características sobredimensionado, reemplazándolo con una versión anterior.

Causa raíz del problema

Prince explicó que el problema se originó por un cambio en los permisos de uno de los sistemas de bases de datos, lo que provocó que la base de datos generara múltiples entradas en un “archivo de características” utilizado por el sistema de gestión de bots. Este archivo, a su vez, duplicó su tamaño y se propagó a todas las máquinas que componen la red de Cloudflare.

Estas máquinas ejecutan software que enruta el tráfico a través de la red de Cloudflare. El software “lee este archivo de características para mantener actualizado nuestro sistema de gestión de bots con las amenazas en constante evolución”, explicó Prince. “El software tenía un límite en el tamaño del archivo de características que era inferior a su tamaño duplicado. Eso causó que el software fallara”.

Disculpas por el impacto

Tras reemplazar el archivo de características inflado con una versión anterior, el flujo de tráfico central “en gran medida” volvió a la normalidad, según Prince. Sin embargo, tomó otras dos horas y media “mitigar el aumento de carga en varias partes de nuestra red a medida que el tráfico volvía a estar en línea”.

Al igual que Amazon Web Services, Cloudflare es utilizado por muchos servicios en línea, por lo que un problema técnico puede afectar a gran parte de la web. “En nombre de todo el equipo de Cloudflare, me gustaría disculparme por el dolor que causamos a Internet hoy”, escribió Prince, afirmando que cualquier interrupción es inaceptable debido a “la importancia de Cloudflare en el ecosistema de Internet”.

El sistema de gestión de bots de Cloudflare clasifica los bots como buenos o malos mediante “un modelo de aprendizaje automático que utilizamos para generar puntuaciones de bots para cada solicitud que atraviesa nuestra red”, explicó Prince. “Nuestros clientes utilizan las puntuaciones de los bots para controlar qué bots pueden acceder a sus sitios, o no”.

Prince explicó que el archivo de configuración en el que se basa este sistema describe “características”, o rasgos individuales “utilizados por el modelo de aprendizaje automático para hacer una predicción sobre si la solicitud fue automatizada o no”. Este archivo se actualiza cada cinco minutos “y se publica en toda nuestra red, lo que nos permite reaccionar a las variaciones en los flujos de tráfico a través de Internet. Nos permite reaccionar a nuevos tipos de bots y nuevos ataques de bots. Por lo tanto, es fundamental que se despliegue con frecuencia y rapidez a medida que los malos actores cambian sus tácticas rápidamente”.

Respuesta inesperada de la consulta

Cada nueva versión del archivo se genera mediante una consulta que se ejecuta en un clúster de base de datos ClickHouse, según Prince. Cuando Cloudflare realizó un cambio que concedía permisos adicionales a los usuarios de la base de datos, la respuesta de la consulta contuvo repentinamente más metadatos de los que tenía anteriormente.

El personal de Cloudflare asumió “que la lista de columnas devuelta por una consulta como esta sólo incluiría la base de datos ‘por defecto'”. Pero la consulta no incluía un filtro para el nombre de la base de datos, lo que provocó que devolviera duplicados de columnas, escribió Prince.

Este es el tipo de consulta que utiliza el sistema de gestión de bots de Cloudflare “para construir cada ‘característica’ de entrada para el archivo”, escribió. Los metadatos adicionales duplicaron con creces las filas en la respuesta, “afectando en última instancia al número de filas (es decir, características) en la salida final del archivo”, escribió Prince.

El servicio proxy de Cloudflare tiene límites para evitar el consumo excesivo de memoria, y el sistema de gestión de bots tiene “un límite en el número de características de aprendizaje automático que se pueden utilizar en tiempo de ejecución”. Este límite es de 200, muy por encima del número real de características utilizadas.

“Cuando el archivo defectuoso con más de 200 características se propagó a nuestros servidores, se alcanzó este límite, lo que provocó que el sistema entrara en pánico” y emitiera errores, escribió Prince.

La peor interrupción desde 2019

El número de códigos de estado HTTP 5xx servidos por la red de Cloudflare es normalmente “muy bajo”, pero se disparó después de que el archivo defectuoso se extendiera por la red. “El pico, y las fluctuaciones posteriores, muestran que nuestro sistema está fallando debido a la carga del archivo de características incorrecto”, escribió Prince. “Lo notable es que nuestro sistema se recuperaría entonces durante un período. Este fue un comportamiento muy inusual para un error interno”.

Este comportamiento inusual se explicó por el hecho de “que el archivo se generaba cada cinco minutos mediante una consulta que se ejecutaba en un clúster de base de datos ClickHouse, que se estaba actualizando gradualmente para mejorar la gestión de permisos”, escribió

Fuente original: ver aquí