Un desarrollador aficionado que construye modelos de lenguaje de IA en inglés victoriano “solo por diversión” recibió una lección de historia inesperada esta semana cuando su última creación mencionó protestas reales de Londres de 1834, eventos que el desarrollador no sabía que habían ocurrido hasta que los buscó en Google.

“Me interesaba saber si realmente había ocurrido una protesta en 1834 en Londres y efectivamente sucedió,” escribió el usuario de Reddit Hayk Grigorian, estudiante de ciencias de la computación en el Muhlenberg College de Pensilvania.

Durante el último mes, Grigorian ha estado desarrollando lo que llama TimeCapsuleLLM, un pequeño modelo de lenguaje de IA (similar a un primo distante de ChatGPT) que ha sido entrenado exclusivamente con textos de Londres de 1800 a 1875. Grigorian busca capturar una voz victoriana auténtica en las salidas del modelo de IA, lo que resulta en textos cargados de referencias bíblicas y excesos retóricos propios de la época.

El proyecto de Grigorian se une a un creciente campo de investigadores que exploran lo que algunos llaman “Modelos de Lenguaje Histórico de Gran Escala” (HLLMs) si cuentan con un modelo base más grande que el pequeño que está utilizando. Proyectos similares incluyen MonadGPT, que fue entrenado con 11,000 textos de 1400 a 1700 d.C. y puede discutir temas utilizando marcos de conocimiento del siglo XVII, y XunziALLM, que genera poesía china clásica siguiendo reglas formales antiguas. Estos modelos ofrecen a los investigadores la oportunidad de interactuar con los patrones lingüísticos y procesos de pensamiento de épocas pasadas.

Según Grigorian, la salida más intrigante de TimeCapsuleLLM surgió de una prueba simple. Cuando lo provocó con “Era el año de nuestro Señor 1834”, el modelo de IA, que está entrenado para continuar el texto desde donde un usuario lo deja, generó lo siguiente:

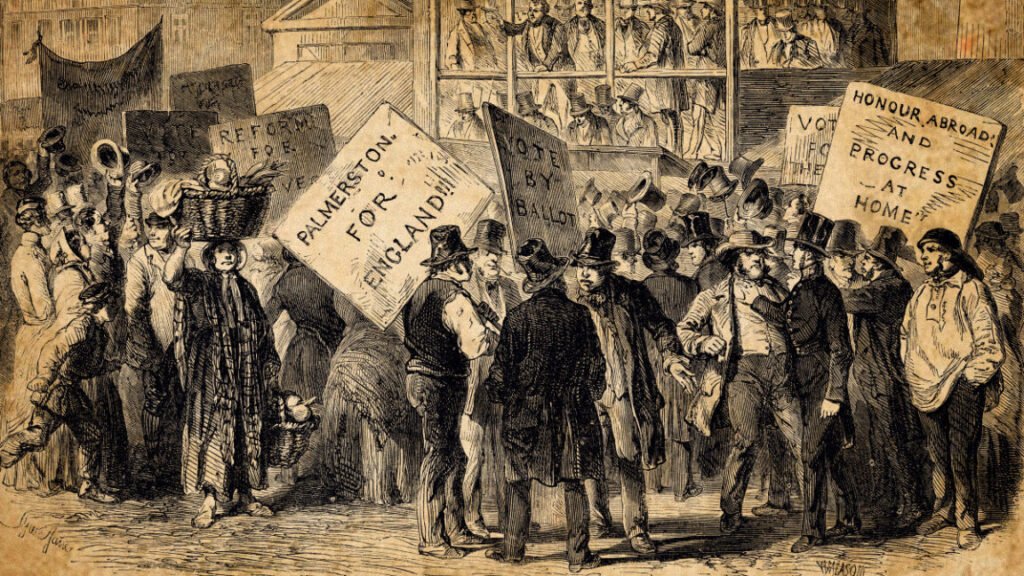

Era el año de nuestro Señor 1834 y las calles de Londres estaban llenas de protestas y peticiones. La causa, como muchos relatan, no estaba limitada de manera privada, sino que habiendo tomado el mismo día en el día del Lord Palmerston, el público recibirá una breve declaración de las dificultades bajo las cuales el día de la ley nos ha alcanzado. Es un asunto de profundo pesar que los eventos actuales en la historia del mundo son claros y, en consecuencia, serán conocidos. No es cierto que los mismos hombres que primero se establecieron en el Evangelio en Jerusalén deban tener un registro tan extenso e interesante de la prosperidad y el bienestar.

Curioso sobre la precisión, Grigorian realizó una verificación de hechos. “La salida también mencionó a Lord Palmerston,” escribió, “y después de buscar en Google, aprendí que sus acciones resultaron en las protestas de 1834.”

Los detalles mencionados en el texto generado por la IA parecen alinearse con hechos históricos: 1834 vio un significativo descontento civil en Inglaterra tras la Ley de Enmienda de los Pobres de 1834, y Palmerston fue Secretario de Relaciones Exteriores de Gran Bretaña durante este período turbulento, y más tarde se convirtió en primer ministro.

Por un lado, esta salida no es muy sorprendente. Los investigadores de IA que crean modelos de lenguaje de IA como los que alimentan a ChatGPT han sabido durante años que estos modelos pueden sintetizar permutaciones realistas de información aprendida de esos textos. Es así como funciona cada asistente de IA hoy en día.

Sin embargo, lo que hace que este episodio sea especialmente interesante es que un pequeño modelo aficionado entrenado por una sola persona parece haberlo sorprendido al reconstruir un momento histórico coherente a partir de referencias dispersas en miles de documentos, conectando un año específico con eventos y figuras reales sin haber sido explícitamente enseñado estas relaciones. Grigorian no había entrenado intencionalmente al modelo con documentación sobre las protestas de 1834; la IA ensambló estas conexiones a partir de los patrones ambientales en 6.25GB de escritura de la era victoriana.

“Todo esto proviene de solo 5-6GB de datos,” escribió Grigorian en Reddit. “Imagina los resultados con 30GB o más. No estoy seguro de si simplemente aumentar el volumen de datos resultará en razonamiento, pero incluso ahora se siente un poco como un viaje en el tiempo digital.”

Viaje lingüístico a través de estadísticas

En lugar de afinar modelos de lenguaje de IA en fuentes de texto modernas, el desarrollador Hayk Grigorian entrena sus modelos de IA aficionados desde cero utilizando exclusivamente fuentes de la era victoriana: más de 7,000 libros, documentos legales y periódicos publicados en Londres entre 1800 y 1875. Él llama al proceso “Entrenamiento Temporal Selectivo” o STT. Un tokenizador personalizado que divide palabras en representaciones simplificadas para un procesamiento más fácil excluye completamente el vocabulario moderno.

“Si ajusto algo como GPT-2, ya está pre-entrenado y esa información no se irá,” explicó Grigorian en GitHub sobre la contaminación de datos modernos. “Si entreno desde cero, el modelo de lenguaje no pretenderá ser antiguo, simplemente será.”

Utilizando arquitecturas de los “modelos de lenguaje pequeños” nanoGPT y de Microsoft Phi 1.5, Grigorian ha entrenado hasta ahora tres modelos de IA, cada uno mostrando una mejor coherencia histórica. La versión 0, entrenada con solo 187MB, producía incoherencias al estilo victoriano. La versión 0.5 logró prosa gramaticalmente correcta de la época pero alucinó hechos. La versión actual de 700 millones de parámetros, entrenada en una GPU A100 alquilada, ha comenzado a generar referencias históricas como la mencionada anteriormente.

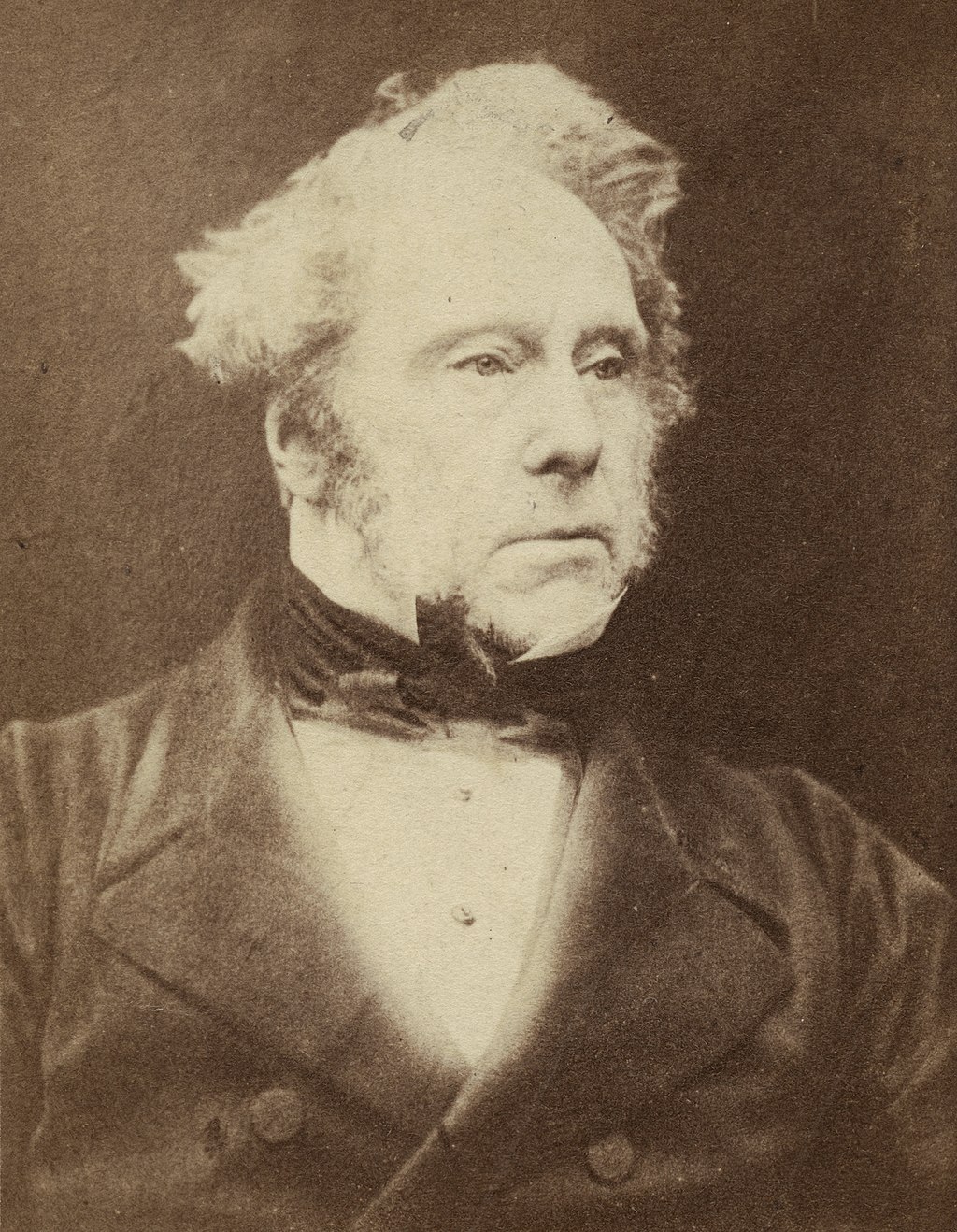

Crédito:

Herbert Watkins (Dominio Público)

Grigorian está encontrando una reducción en las confabulaciones con el tiempo como el efecto emergente de escalar el tamaño de datos de entrenamiento de alta calidad, un efecto bien conocido entre los investigadores de IA, especialmente cuando los modelos son muy pequeños. “Los modelos anteriores (v0 y v0.5) podían imitar los estilos de escritura del siglo XIX, pero siempre alucinaban eventos, personas y hechos,” escribió Grigorian en GitHub. “Esto muestra que el modelo está comenzando a recordar cosas del conjunto de datos.”

Para historiadores e investigadores de humanidades digitales, estos tipos de experimentos pueden ser útiles. Entrenar modelos de lenguaje de IA con textos de época puede permitir la creación de modelos lingüísticos interactivos de la época que ofrezcan a un investigador la oportunidad de conversar con un hablante simulado de un vernacular o lenguaje extinto del pasado. Los resultados no necesariamente serían rigurosos en cuanto a hechos debido a las confabulaciones, pero podrían ser estilísticamente iluminadores para alguien que estudie la sintaxis o el vocabulario antiguos en uso.

“Quiero intentar eventualmente diferentes ciudades, tal vez un modelo de una ciudad china, rusa o india,” escribió Grigorian invitando a la colaboración con otros en futuros modelos de IA que podría entrenar. Hace que el código, los pesos del modelo de IA y la documentación de su trabajo sean disponibles públicamente en GitHub.

En una era de frecuentes confabulaciones de IA, hay algo refrescante en un modelo que accidentalmente dice la verdad sobre el pasado. Es casi lo opuesto a la alucinación: un modelo de IA que accidentalmente obtiene algo correcto. Se podría llamar un “hecho-accidente”.

Fuente original: ver aquí